Zajmujemy się przetwarzaniem danych na potrzeby e-commerce, SEO, analiz danych.

Przy naszym głównym projekcie Blinked analizujemy dzięki crawlerom dane na potrzebny SEO. Parsowane są strony, poddawane automatycznej analizie pod kątem SEO. Parsowanie danych obejmuje tutaj wszystkie istotne czynniki dla skutecznego procesu optymalizacji onsite min:

- Nagłówki, meta dane

- Linkowanie wewnętrzne

- Czasy odpowiedzi, czasy ładowania podstron

- Błedy składoniowe, błędy w linkowaniu

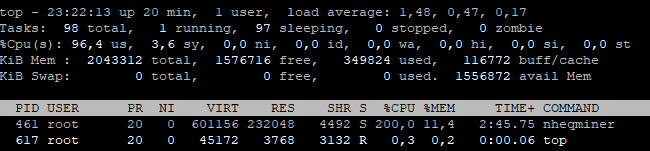

Pobieranych i analizowanych parametrów dla każdej podstrony serwisu jest kilkadziesiąc i w jednym momencie analizujemy kilkadziesiąt serwisów zarówno małych które mają parę podstron po duże ecommerce z milionami podstron. Mamy do tego odpowiednia infrastrukturę którymi są nasze klastry oraz serwery w zewnętrznych serwerowniach

Jakim sprzętem parsujemy dane

Łącznie mamy do dyspozycji szafę serwerową z 10 maszynami spiętymi w klastrze proxmox:

Mamy łącznie 64 rdzeni na Intel Xeon, 320 GB RAM, i 10TB powierzchni w samym klastrze. Oczywiście jest też klaster BeoWulf czyli diskless klaster złożony ze starych kompów który przetwarza też zadania związane z parsowaniem danych z serwisów

Oba klastry działają na systemie Linux Debian który uwielbiamy i jest królem wszystkich systemów operacyjnych. Na klastrze proxmox mamy ponad 40 maszyn wirtualnych głownie są to kolejne kontenery LXC.

Parsowanie danych – jakie dane przetwarzamy

- Crawlowanie serwisów na potrzeby SEO

- Pobieranie danych z product feedów

- Wyciąganie danych z serwisów internetowych

- Łączenie danych z różnych źrodeł

- Pobieranie informacji o domenach

- Wyszukwianie źrodeł danych

- Sprawdzanie zmian na stronie i zpaisywanie ich historii

Dane praktycznie pobieramy w trybie ciągłym, jednorazowo jesteśmy w stanie pobierać dane z kilkuste serwisów, ewnetuana rozbudowa klastra to kwestia podłączenia kolejnej maszyny bez dysku twardego która automatycznie staje się kolejnym nodem